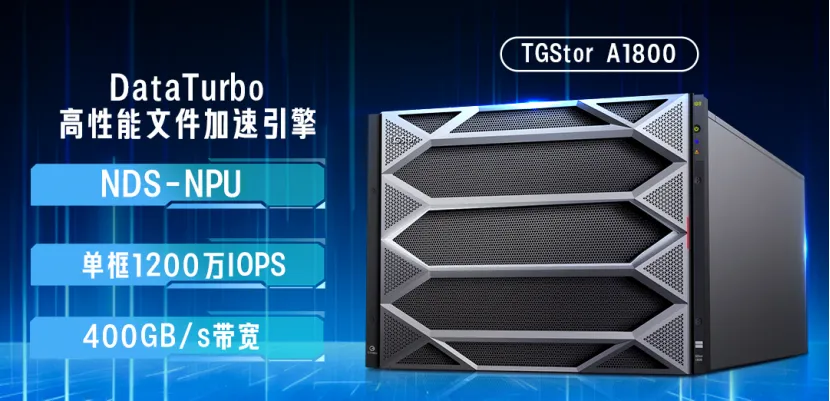

DeepSeek千亿参数如何存得下存得好?GPU高带宽内存容量成为瓶颈?发表时间:2025-02-11 16:40 在人工智能技术飞速发展的今天,大模型的训练与推理已成为推动AI应用落地的核心驱动力。然而,随着模型参数规模的指数级增长(如DeepSeek-R1的6710亿参数),存储与计算资源的瓶颈问题日益凸显。如何在高性能与低成本之间找到平衡,成为各大科技企业竞相突破的关键。一、DeepSeek的挑战与创新:存储瓶颈的突破 DeepSeek-R1作为一款拥有6710亿参数的大模型,凭借其卓越的推理能力和低成本优势,在市场上引发了广泛关注。然而,随着模型复杂度的提升,推理过程中需要缓存的上下文数据(如KV Cache)呈指数级增长,导致GPU高带宽内存容量成为瓶颈。传统的解决方案是通过增加DRAM来扩展内存,但这会显著推高推理成本。 DeepSeek通过创新的缓存技术,将GPU和DRAM中的缓存数据卸载到存储阵列中,成功将大模型使用成本降低一个数量级。这种“以存代算”的策略不仅缓解了内存压力,还显著降低了服务延迟和最终使用成本。然而,DeepSeek的缓存技术对存储性能提出了更高的要求——需要存储系统具备极高的带宽、低延迟和海量扩展能力,以支持大规模KV Cache的快速读写。 图源:网络 二、华存智谷TGStor A1800:为AI而生的高性能存储 华存智谷TGStor A1800正是为满足这一需求而设计的下一代高性能AI存储。其核心特性与DeepSeek的技术需求高度契合,为AI大模型的训练与推理提供了强有力的存储支持。 极致性能:满足KV Cache的高效读写 TGStor A1800通过NDS直通NPU和DataTurbo高性能文件加速引擎,实现了单框1200万IOPS和400GB/s带宽的极致性能。这种性能水平能够轻松应对DeepSeek推理过程中大规模KV Cache的读写需求,显著降低服务延迟。 通过数控分离架构和DPU卸载CPU算力,TGStor A1800实现了数据读写直通到盘,减少了CPU和内存的负担,进一步提升了数据加载效率。 海量扩展:支持大模型的平滑演进 TGStor A1800支持单集群512控Scale-out扩展,EB级存储容量,能够满足万亿/十万亿参数大模型的平滑演进需求。这种扩展能力与DeepSeek的硬盘缓存技术完美结合,为大模型的长序列处理和多轮对话场景提供了强大的存储支持。 通过灵活的算力卡扩展(如DPU、GPU),TGStor A1800还能够加速数据处理,支持加密、压缩、向量检索等多种功能卸载,进一步提升推理效率。 智能推理:优化长记忆与向量检索 TGStor A1800内置高性能向量检索引擎,支持向量数据范式,能够加速大库容向量知识库检索,减少推理“幻觉”。这一特性与DeepSeek的多轮对话场景高度契合,能够通过缓存历史对话内容,显著降低推理时延。 通过支持RAG向量数据库和KVCache技术,TGStor A1800赋予AI大模型长记忆能力,提高推理准确度和效率。

三、DeepSeek与TGStor A1800的协同创新 DeepSeek与TGStor A1800的结合,不仅解决了大模型推理中的存储瓶颈问题,还通过存储与计算的协同创新,重新定义了AI服务的性价比。 以存代算:降低推理成本 DeepSeek的硬盘缓存技术将KV Cache卸载到存储中,而TGStor A1800的高性能存储能力确保了缓存数据的快速读写。这种协同创新将大模型推理成本降低了一个数量级,为AI服务的广泛普及奠定了基础。 长序列处理:提升推理效率 在多轮对话和长序列处理场景中,TGStor A1800的多级KV缓存机制与DeepSeek的硬盘缓存技术相结合,能够显著减少Prefill阶段的重复计算,推理时延降低78%,单个xPU卡吞吐量提升67%。 智能推理:优化用户体验 通过TGStor A1800的向量检索引擎和RAG向量数据库支持,DeepSeek能够实现更精准的推理结果,减少“幻觉”现象,为用户提供更智能、更个性化的服务体验。 图源:网络 四、未来:存储与计算的深度融合 随着大模型参数规模的进一步增长,存储与计算的深度融合将成为必然趋势。通过高性能存储、智能缓存和向量检索等技术的协同创新,AI大模型将能够在更广泛的场景中实现低成本、高效率的推理,加速AI普惠时代的到来。 |